云数据中心特征

高设备利用率

- 通过虚拟化技术(服务器虚拟化、存储虚拟化、网络虚拟化、应用虚拟化)将云平台系统与数据中心硬件资源整合,达到减少物理服务器数量的目标

- 优化资源利用率、简化管理,降低成本、快速响应业务需求的变化等

- 较大的数据中心有更低的单位运营成本:网络、存储、管理

绿色节能

- 服务器本身:节能服务器、节能存储设备、刀片服务器

- 环境:供电技术、散热技术,降低能耗

- 软件:虚拟机等资源调度算法、计算任务管理算法等

高可用性

- 各个部分的冗余、容错、容灾设计

- 扩展和升级时,保持正常运行

自动化管理

- 无人值守,远程管理(系统漏洞与补丁管理、性能管理和瓶颈分析、服务器与操作系统部署、系统功率测量和调整)

- 门禁、通风、温度、湿度、电力均可远程调度与控制

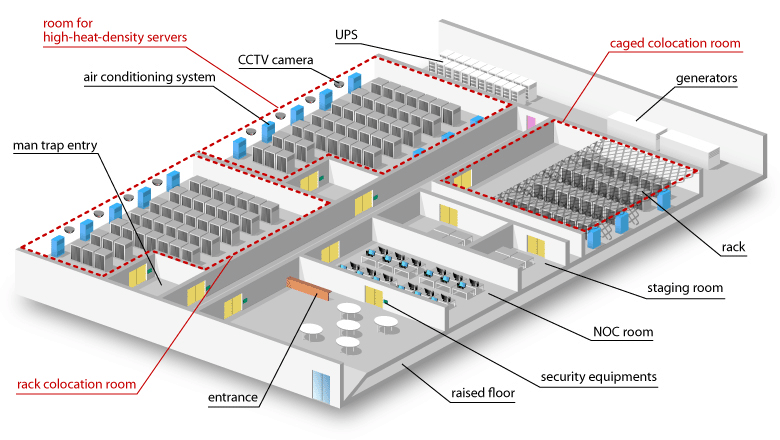

云数据中心网络部署

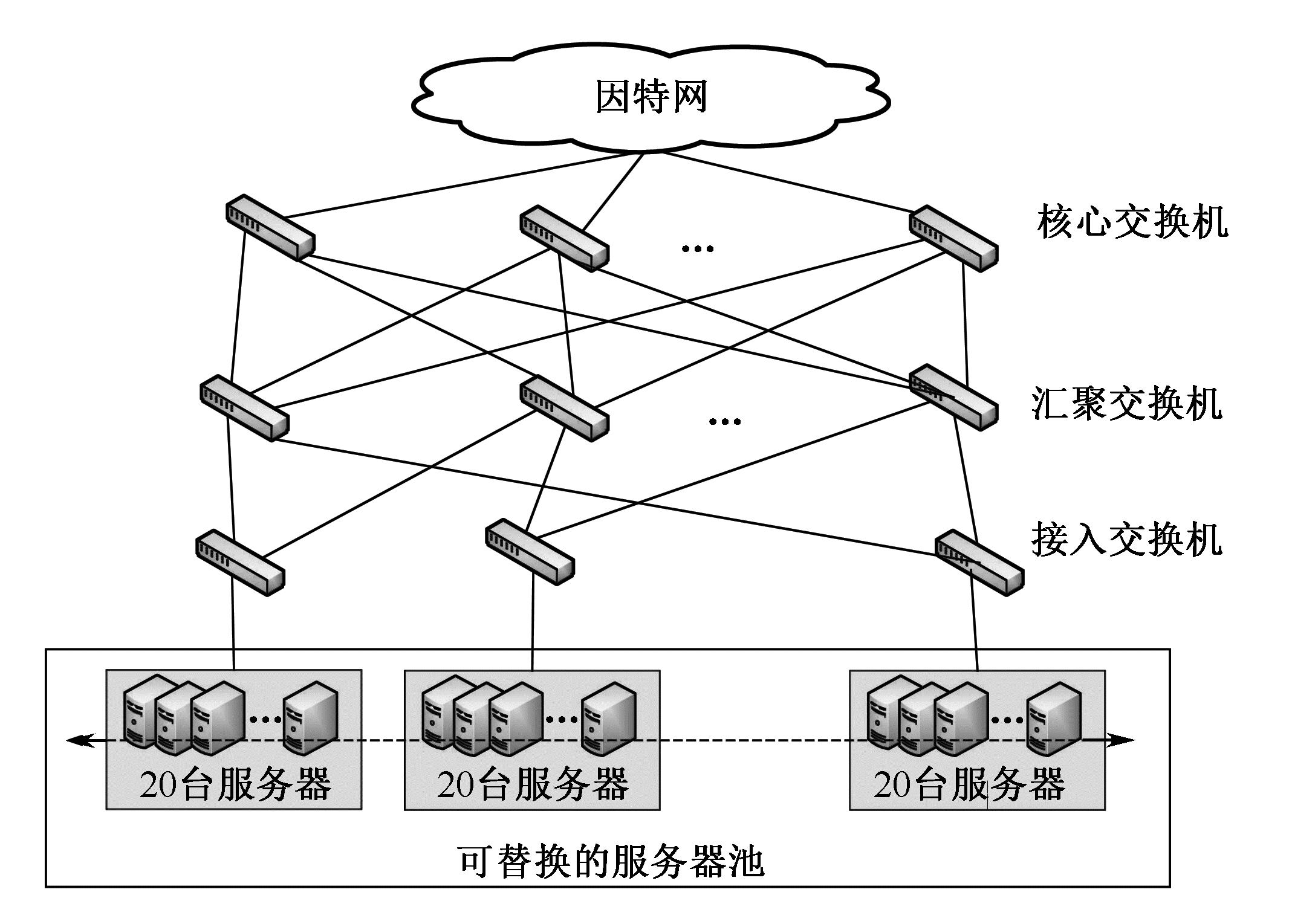

传统树结构

建造方便简单,但不便于拓展与升级,任意一个核心交换机故障导致上千台服务器失效

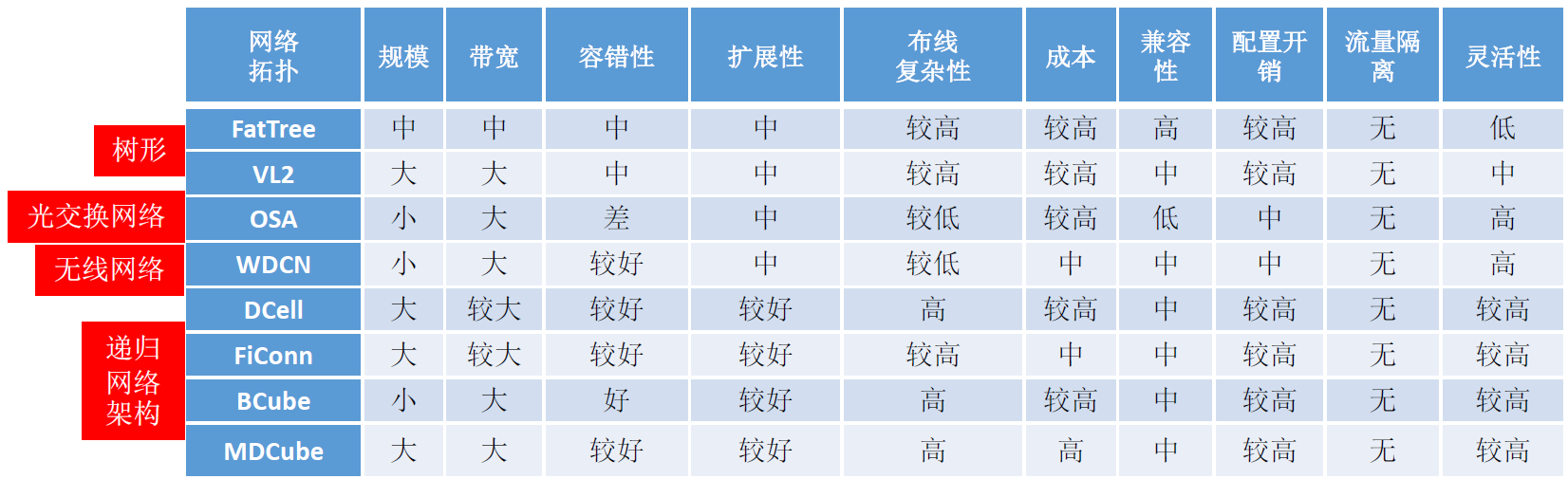

云数据中心对网络架构的需求:低成本、高可扩展性、低配置开销、健壮性、节能

现有数据中心网络结构对比如下:

改进树

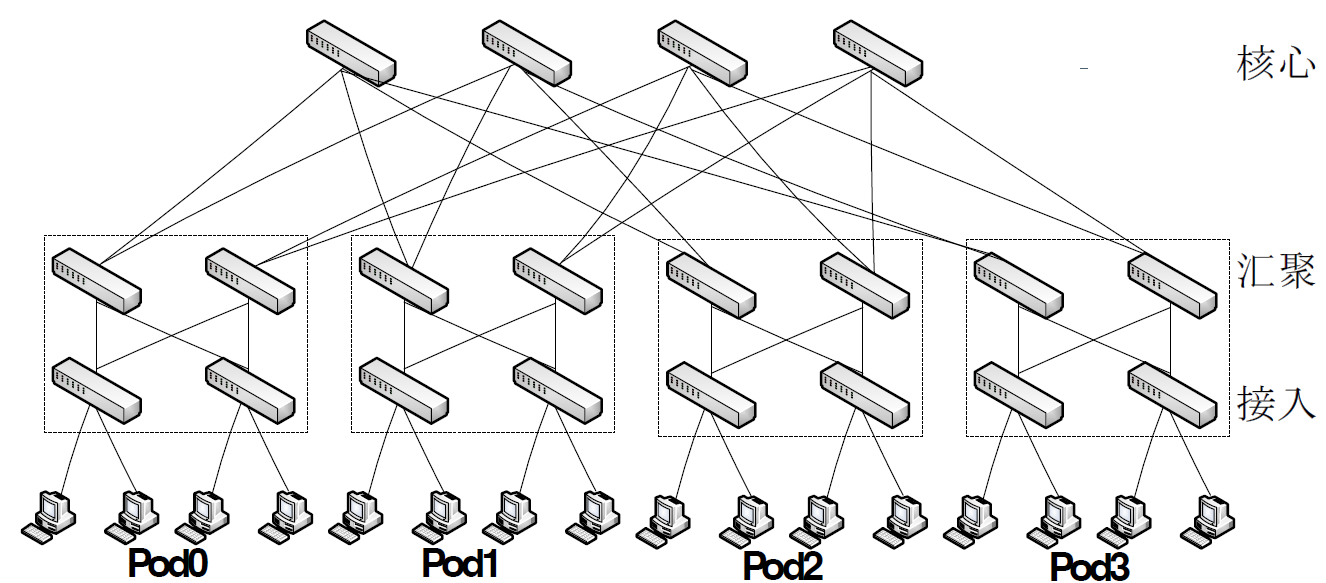

FatTree

- K 叉树,K 个 Pod(集装器),每个 Pod 有 K 个交换机,其中 K/2 个接入交换机,K/2 个汇聚交换机。

- Pod 中每个交换机有 K 个接口,K/2 个接主机,K/2 个接汇聚;K/2 个接接入,K/2 个接核心。

- 有 (K/2)2 个核心交换机,每个交换机 K 个端口接 K 个汇聚交换机。

- 一个 Pod 内的所有交换机相互连接:完全二分图。

- 一个 Pod 内的每个汇聚交换机与一部分核心交换机连接,但是一个 Pod 和每一个核心交换机都有连接。

两级路由表,允许两级前缀查询:Pod 间流量尽可能均匀分布于核心交换机

任意两个不同 Pod 主机之间存在 K 条路径

- 将流量在这些路径间分散

- 任意给定 Pod 的低层和高层交换机对位于本 Pod 的任意子网都有终结性表项

- 在全负载最坏的情况下实现约 87% 的聚合带宽

与传统层次结构相比,FatTree 有如下特点:

- 消除了树形结构上层链路对吞吐量的限制

- 为内部节点间通信提供多条并行链路

- 与现有数据中心网络使用的以太网结构和 IP 配置的服务器兼容

- 但是布线复杂了;扩展时需要重构;受到端口数限制等。

但是,FatTree 的扩展性受限于核心交换机端口数量,目前比较常用的是 48 端口 10G 核心交换机,在 3 层树结构中能够支持 27648 台主机。

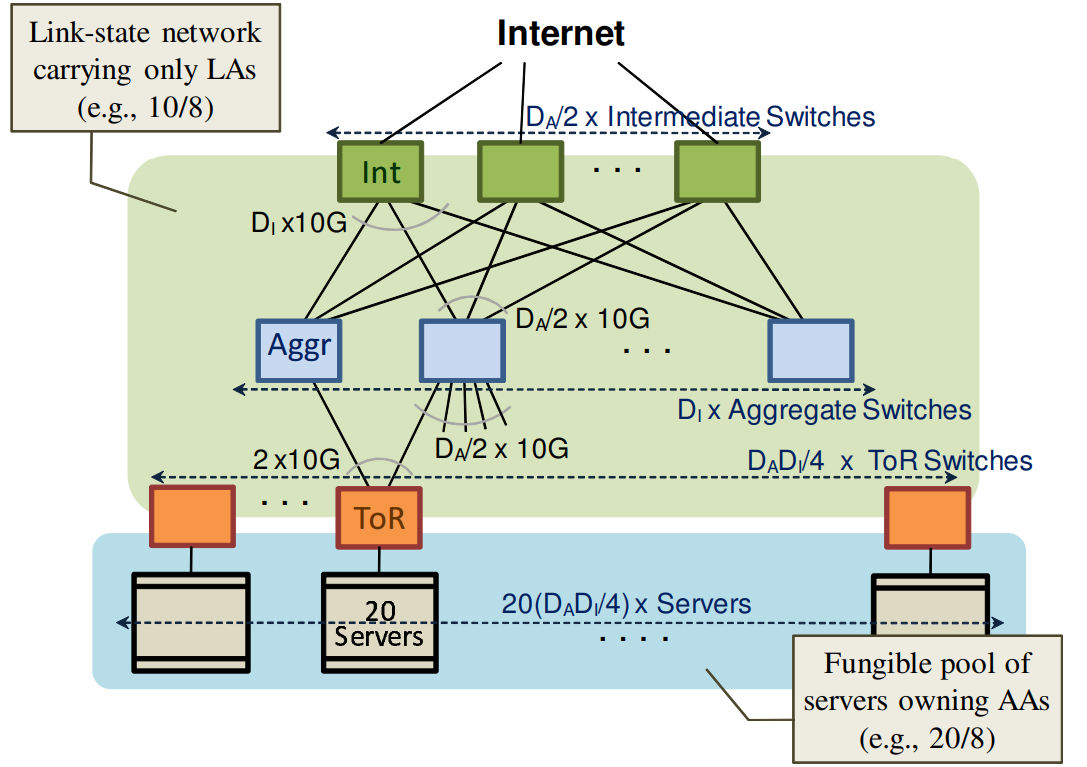

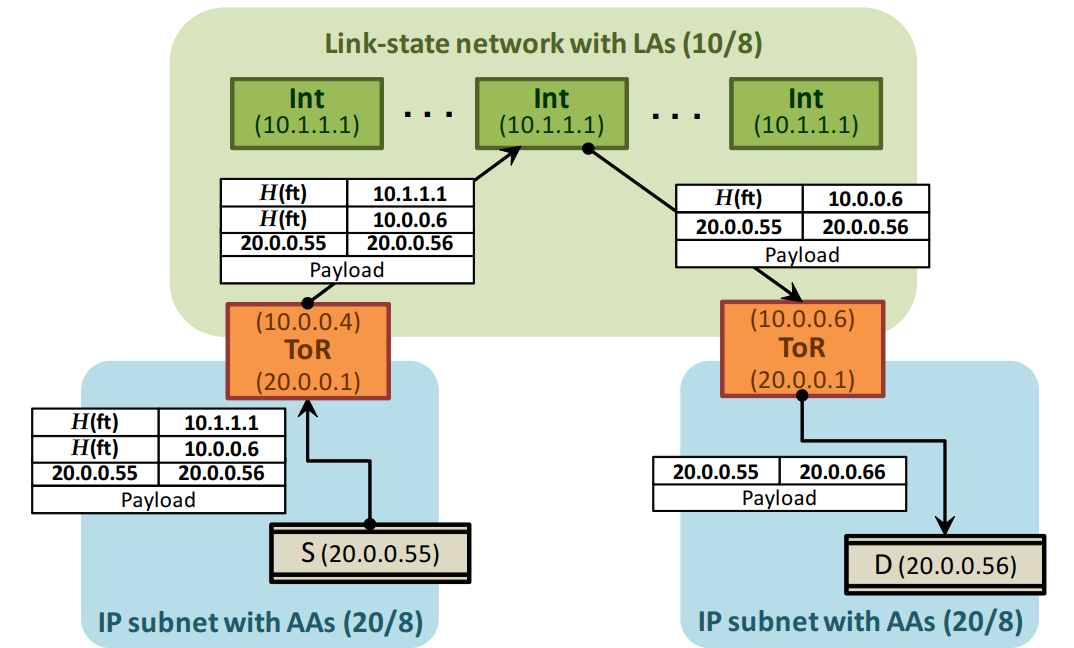

VL2

VL2:一套可扩展且很灵活的网络架构,微软数据中心采用。

- 若干服务器连接到机架(接入)交换机

- 每台接入交换机与两台汇聚交换机连接

- 每台汇聚交换机与所有核心交换机连接

VL2 特点:

- 扁平寻址,允许服务实例被放置到网络覆盖的任何地方

- 负载均衡将流量统一分配到网络路径

- 终端系统的地址解析拓展到巨大的服务器池

核心思想:使用 FatTree 同样的拓扑结构建立扁平的第二层网络

具体机制:

- IP 地址仅仅作为名字使用,没有拓扑含义;将服务器的名字与其位置分开。

- 使用可扩展、可靠的目录系统来维持名字和位置间的映射。

- 当服务器发送分组时,服务器上的 VL2 代理开启目录系统以得到实际的目的位置,然后将分组发送到目的地。

优势:VL2 是目前最易用于对现有数据中心网络改造的结构;应用程序使用服务地址通信而底层网络使用位置信息地址进行转发,使得虚拟机能够在网络中任意迁移而不影响服务质量。

缺点:VL2 依赖于中心化的基础设施来实现 2 层语义和资源整合,面临单点失效和扩展性问题。

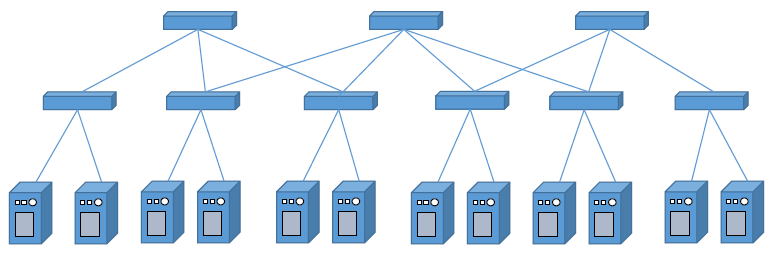

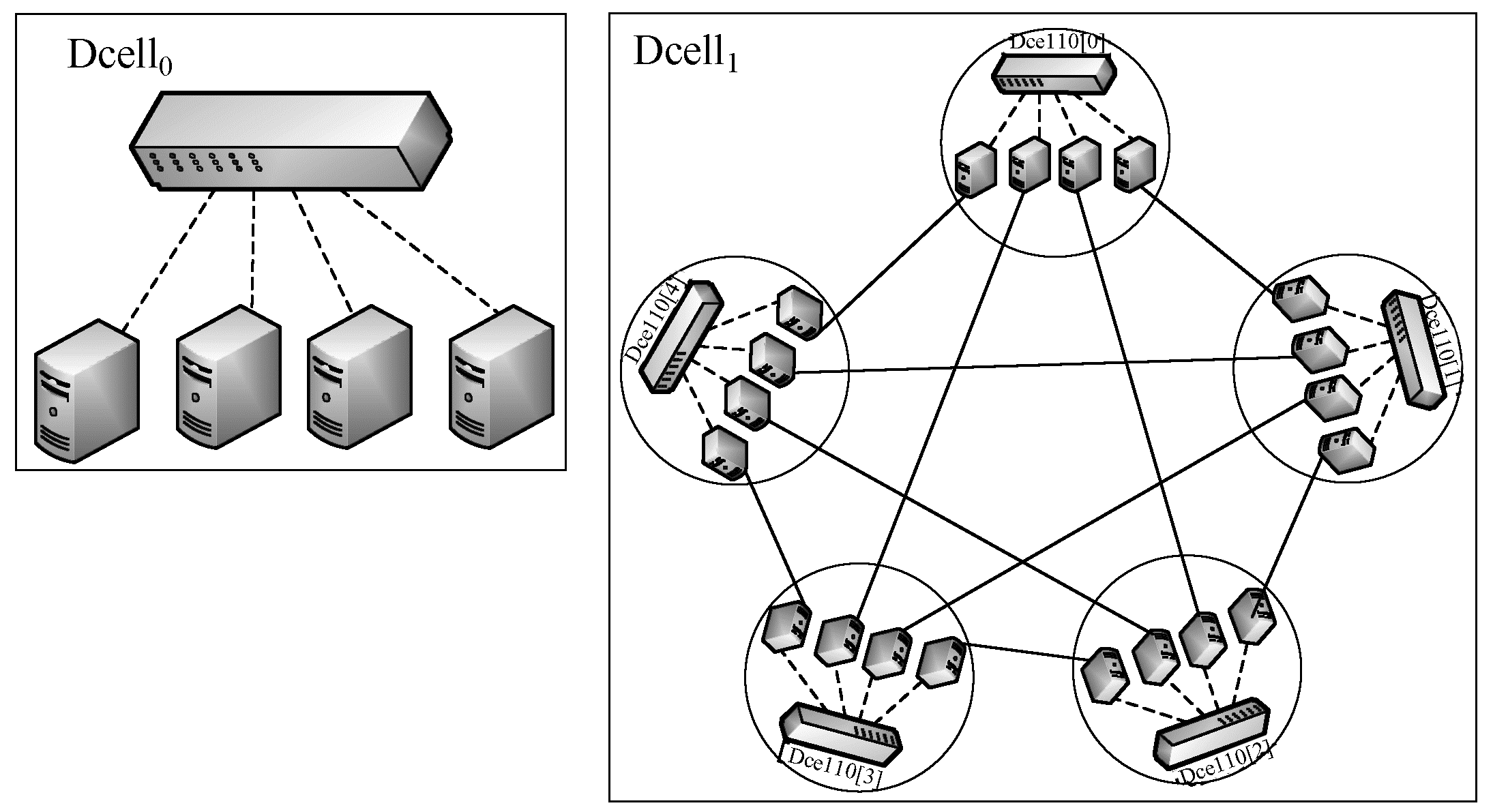

递归层次

解决可扩展性的较好选择:最小递归单元的结构;递归规律

每一个高层的网络拓扑,由多个低层的递归单元按照递归规律相互连接构成,同时也是更高层级网络的一个递归单元。

增加服务器数量==>提高总的递归层次

- 添加服务器更加灵活,可增加的数量增大

- 对交换机性能要求低

递归层次结构:DCell、FiConn、BCube、MDCube

DCell

构建高层次网络时,需要的低层网络的个数等于每个低层网络中的服务器个数加 1。

可扩展性好,拓扑层数受限于服务器端口数

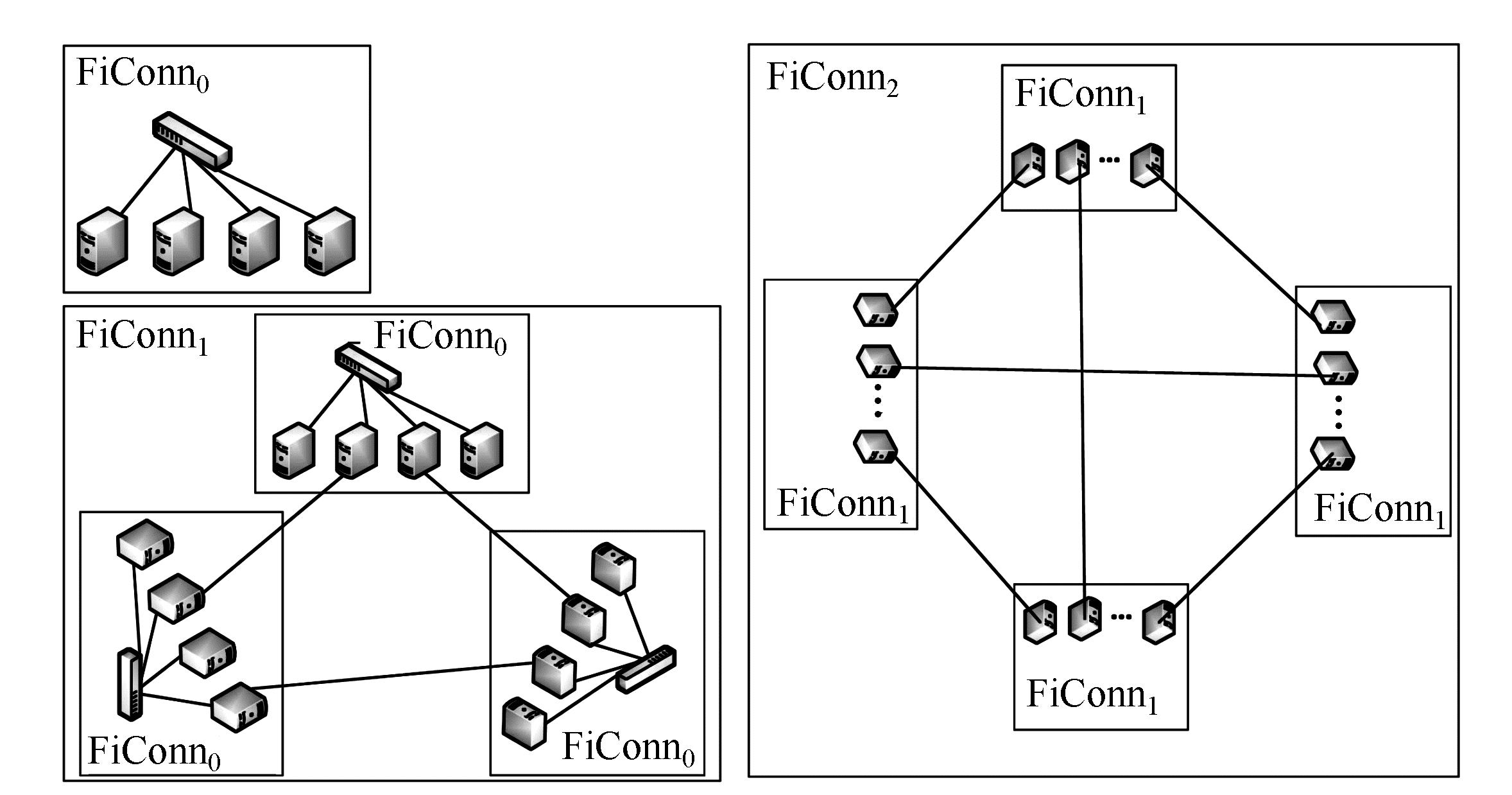

FiConn

服务器使用两个网卡端口:主用端口连接低层网络,备用端口连接高层网络

递归定义的结构:

- 第 0 层为基本构建单元,n 个服务器连接一个具有 n 个端口的交换机

- 每个低层 FiConn 中备用端口空闲的一半服务器与其他相同层次的 FiConn 网络中备用端口空闲的服务器连接

- k 层服务器、k 层端口、k 层链路

不需要对服务器和交换机做修改对外连接的链路有限,容错较弱,链路路径长度大,路由效率不高

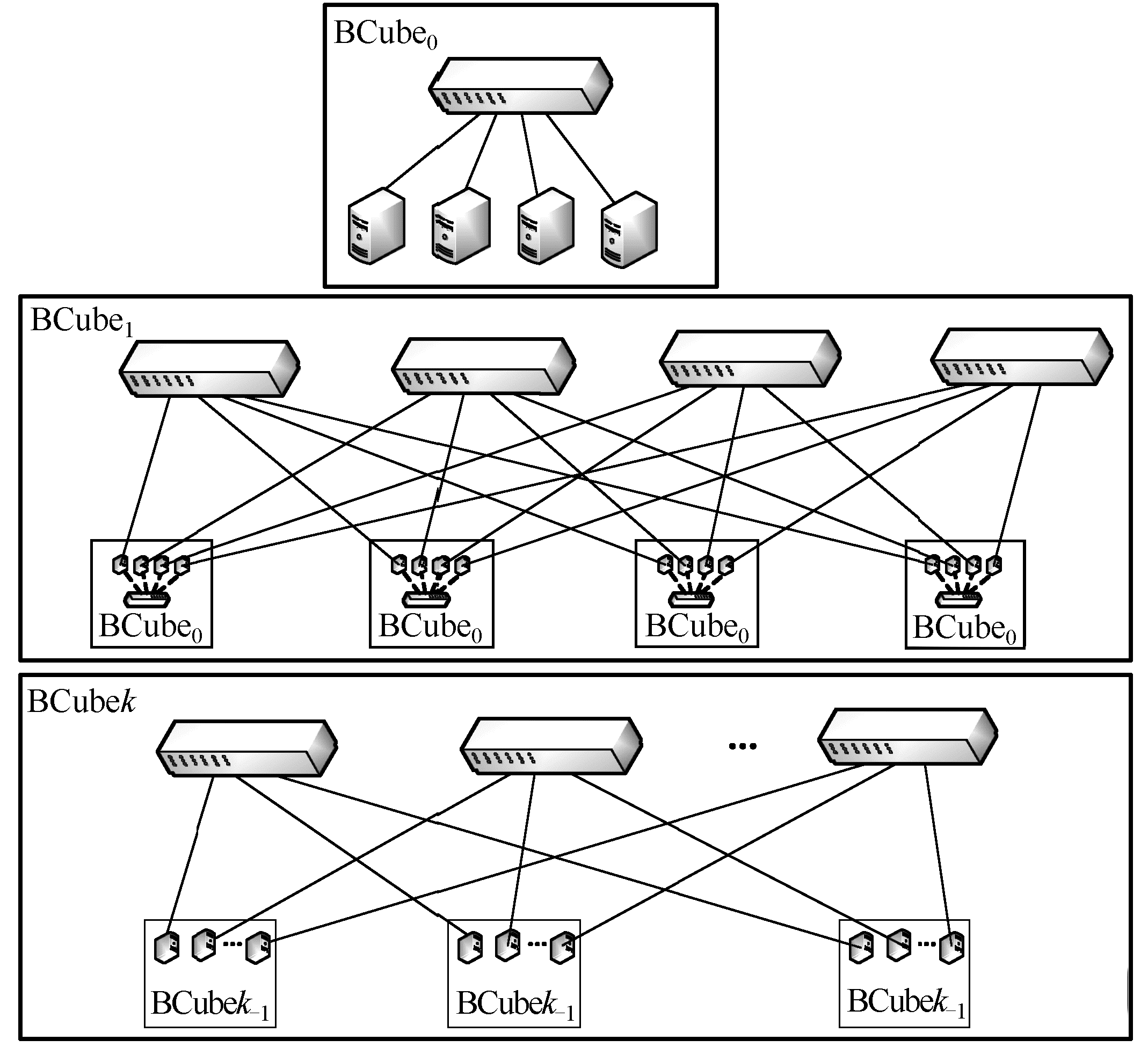

BCube

主要使用交换机构建层次化网络

- 第 0 层:n 服务器连接 1 交换机

- 第 1 层:n 个 0 层连接 n 个交换机

- 第 k 层:n 个 k- 1 层连接 nk 交换机

- 交换机 n 个端口,服务器 k+1 个端口

- 没有明显的瓶颈链路,出现故障时性能优雅下降,服务可用性高

- 服务器间路径多,探测的通信和计算开销大

- 硬件要求特殊:端口数目

光交换网络

业务越来越庞大和复杂,数据中心内部和服务器间的数据流量快速增加,传统网络设备无法处理如此流量的数据——考虑可光速传播数据的设备,需要调整网络拓扑

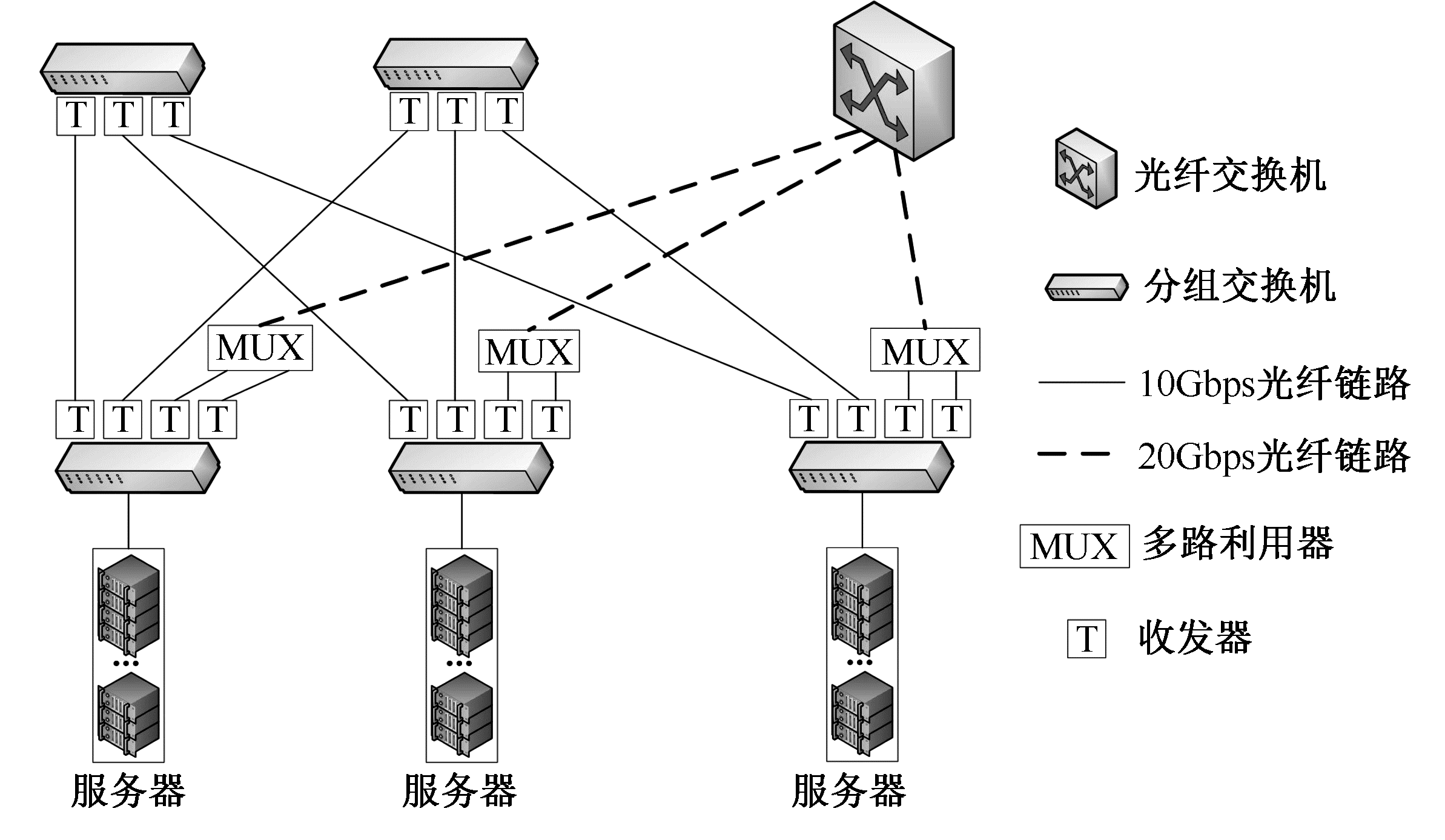

Helios:混合电/光结构网络

- 两层多根树

- 服务器连接接入交换机

- 接入交换机连接电交换和光交换网络

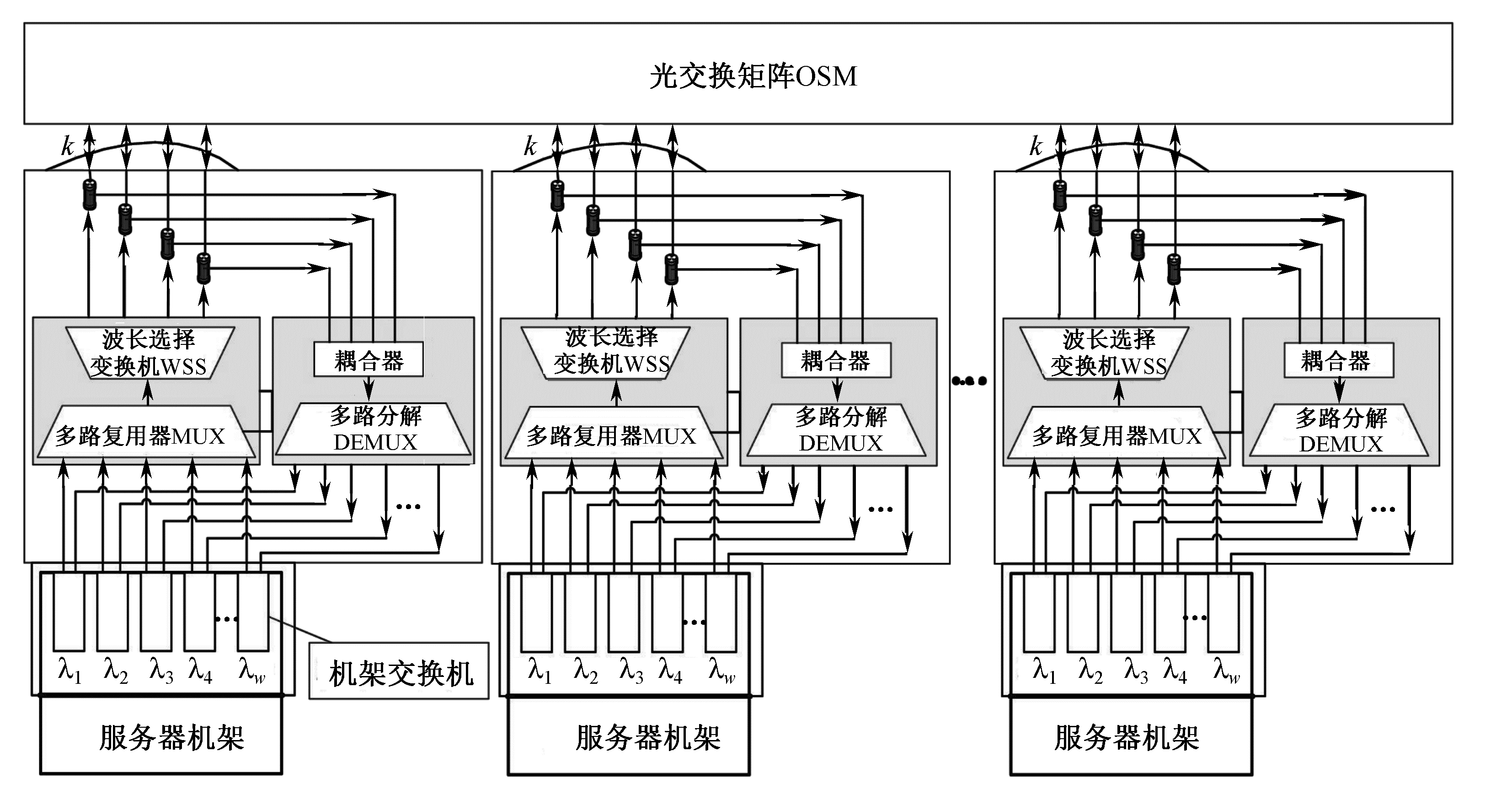

OSA

OSA(Optical Switching Architecture)基于光交换的数据中心网络体系结构。

- 光交换矩阵(OSM,Optical Switching Matrix):任意输入端口可以连接到任意输出端口

- 波长选择交换机(WSS,Wavelength Selective Switch):将从通用端口进入的波长集和分开在 N 个波长端口

更高的传输效率、更灵活拓扑结构、更低的制冷成本

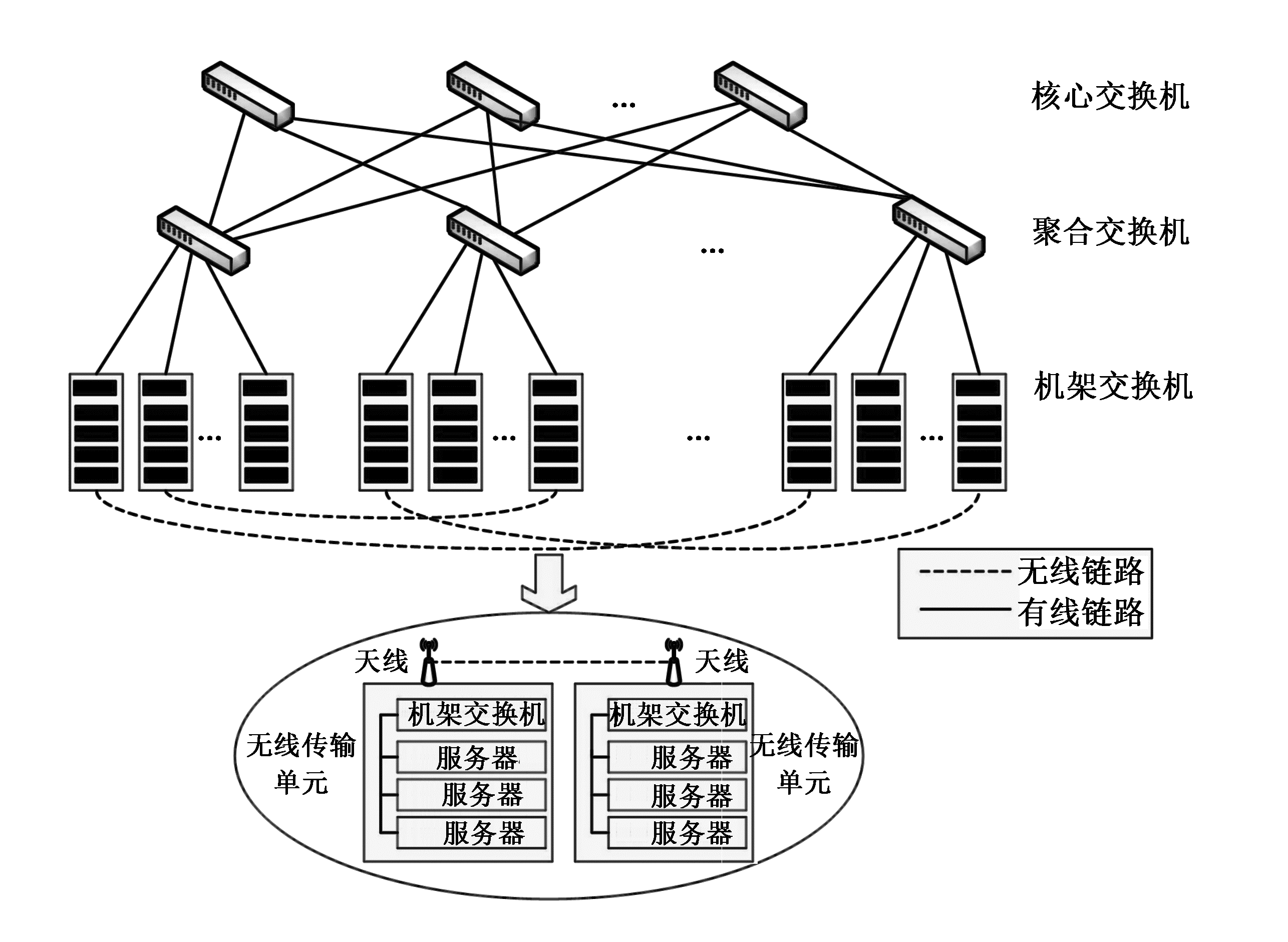

无线数据中心网络

静态链路和有线接口在大量高突发流量和高负载服务器情况下降低数据中心网络性能,无线网络的广播机制克服这个问题。

- Flyways:在过热的交换机间添加无线链路;使用贪心算法将最大流量链路分摊到其他可行路径

- WDCN 异构的以太网/无线体系结构

无需重新布线即可灵活调整拓扑结构

提供足够带宽的前提下传输距离有限

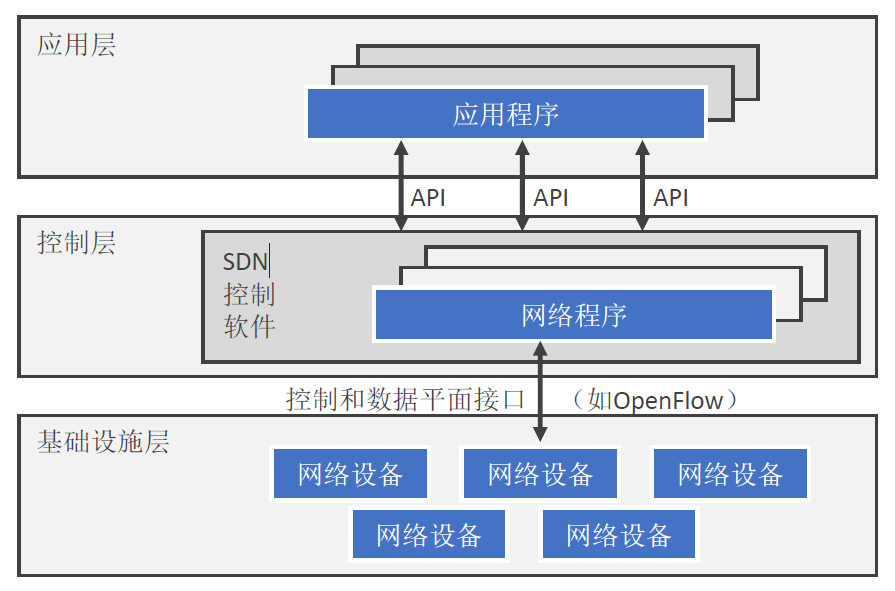

软件定义网络

Software Defined Networking,SDN

将网络的控制平面和数据转发平面分离

- 基础设施层:底层转发设备,根据控制器设定的规则进行数据分组的转发

- 控制器层:即 SDN 控制软件,维护网络状态,向底层提供控制和数据平面接口用于获取底层基础设施信息,向应用层提供可扩展的接口。

- 应用程序层

- 通过软件更新实现网络升级

- 无需针对硬件进行配置

- 数据转发与网络控制解耦

- 简化底层网络设备功能

- 使得网络具备集中协调点

- 加快网络部署周期

- 加速网络创新周期

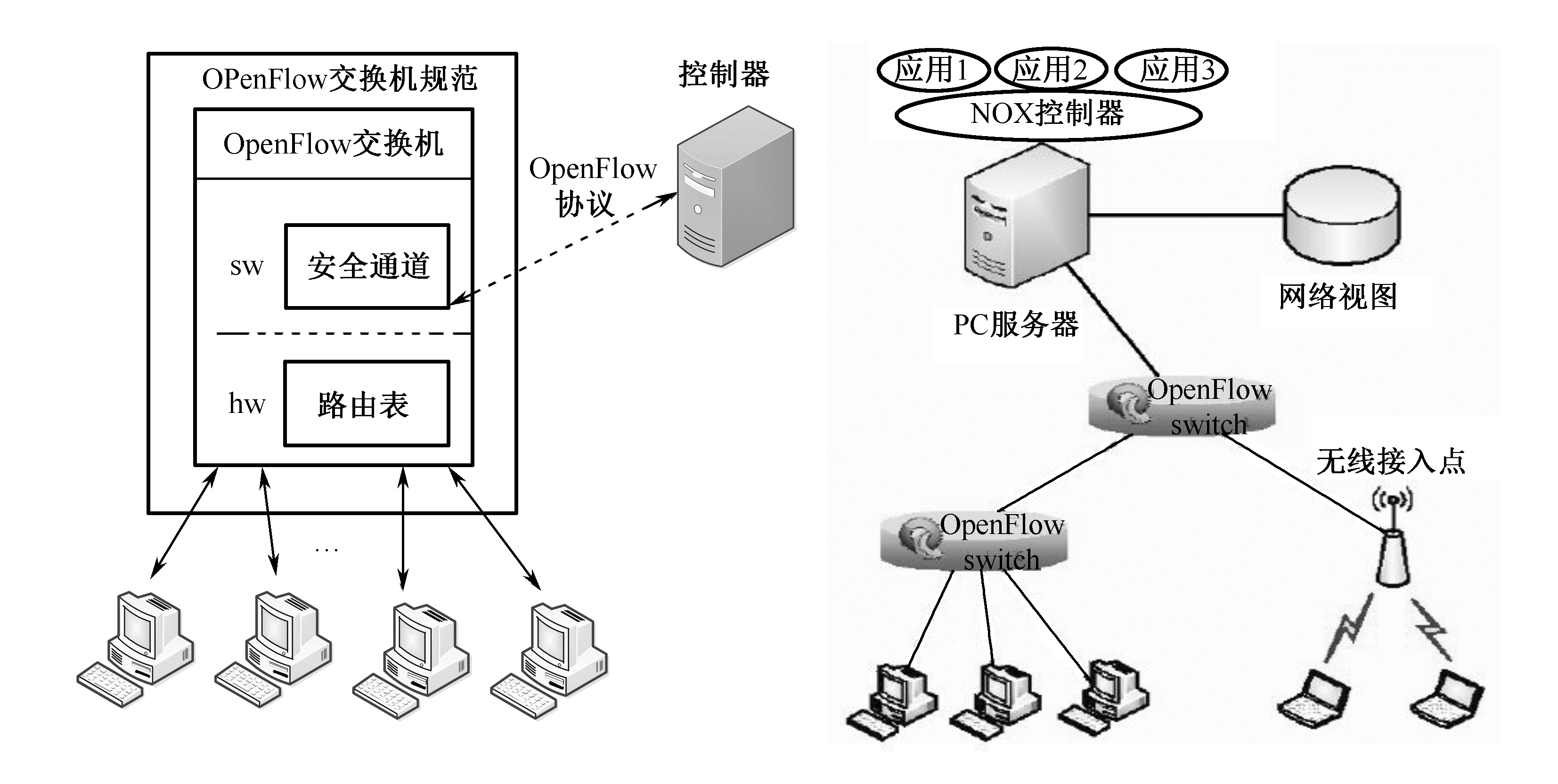

Openflow,第一个针对 SDN 实现的标准接口。

以良好的灵活性、规范性被看成 SDN 通信协议的标准,类似 TCP/IP 作为互联网的标准

起源于斯坦福大学的 Clean Slate 计划(致力于研究重新设计互联网的项目)

- 斯坦福大学高性能网络研究组

- MIT、UC 伯克利分校、Cisco、Juniper

Openflow 交换机、控制器:

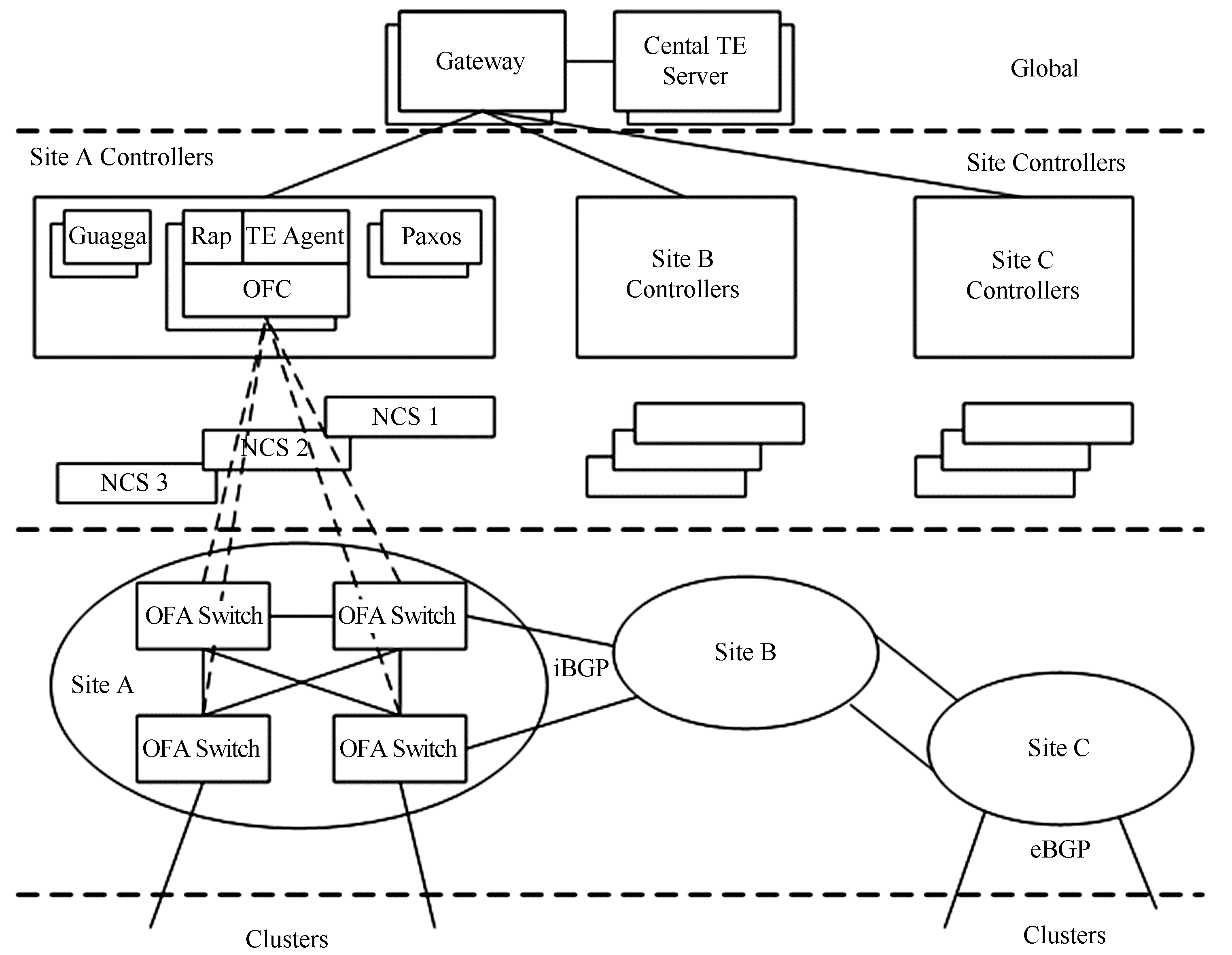

Google 基于 Openflow 的数据中心网络方案。

绿色节能技术

云计算数据中心的耗能越来越大

解决云计算数据中心的高能耗问题已经成为一个环境问题,构建绿色节能的云计算数据中心也成为一个重要的研究热点。

2012 年全球数据中心消耗 7203 亿千瓦时=全球发电量 2%,折合标准煤消耗约 2.6 亿吨。Google 的 100 条搜索用电=60 瓦灯泡持续量 28 分钟

- 配电系统节能

- 空调系统节能

- 集装箱数据中心节能技术

- 管理系统节能策略和算法

- 新能源应用

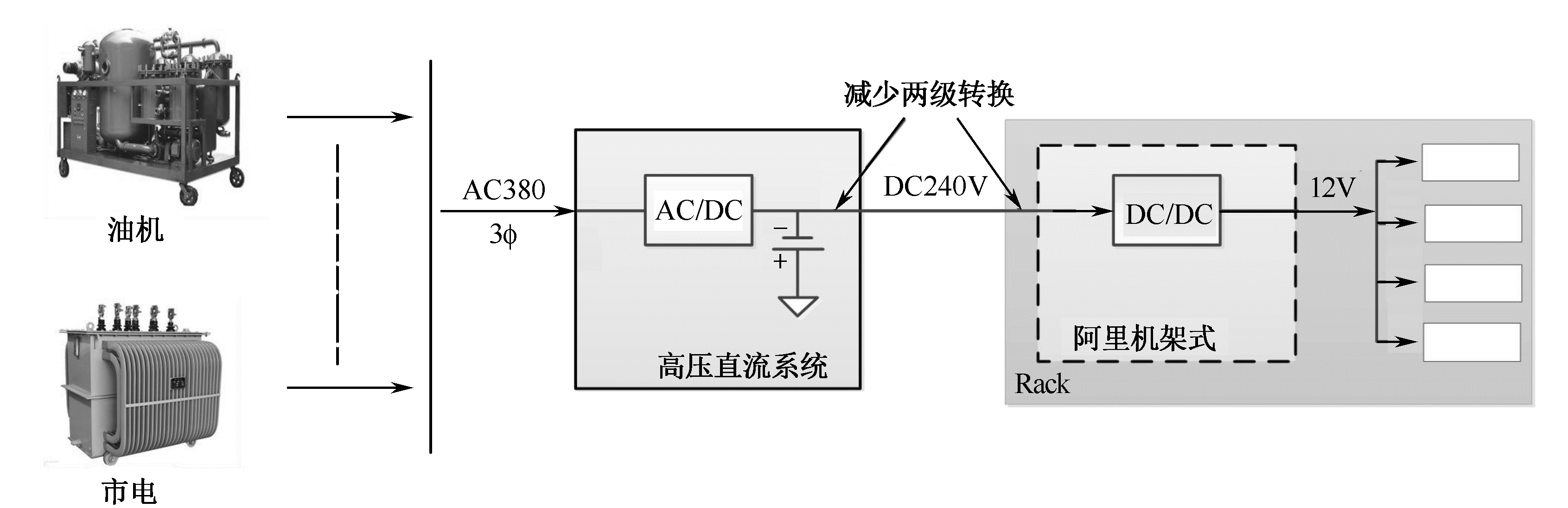

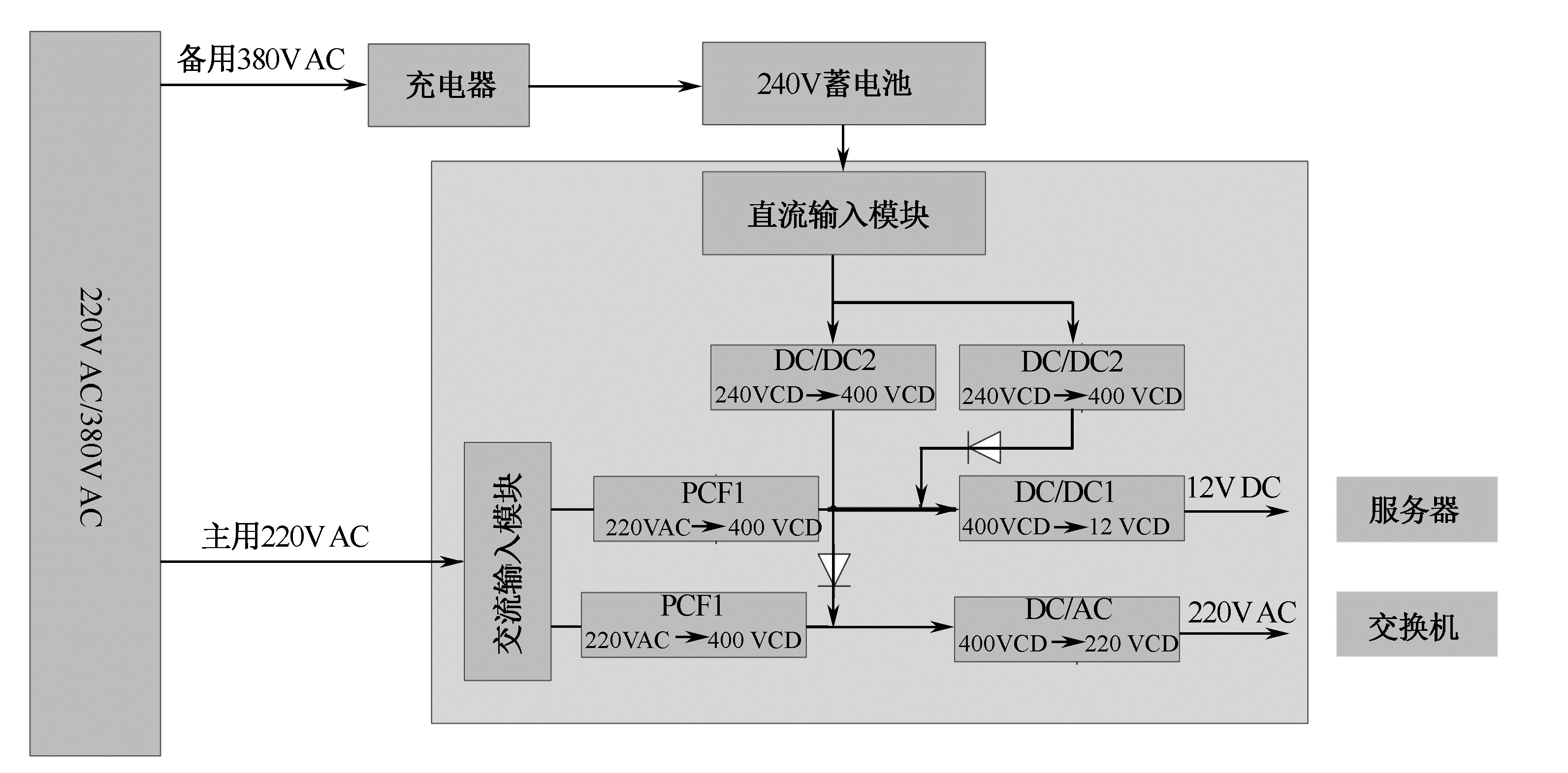

配电系统节能

传统数据中心使用 UPS 系统稳定供电:外部供电系统异常时使用电池系统过度到油机发电

问题:

- 整流逆变两个环节获得标准交流电压给服务器,再变压给主板——转换多、复杂

- 为避免 UPS 单点故障,采用多台 UPS 并机——供电架构复杂、难维护

- UPS 自身消耗大量电能、热量增加空调系统负载——电力损耗 10% 以上

- 传统配电系统效率一般低于 77%——如何改善配电系统得效率成为重要问题

高压直流配电技术:高压直流到服务器、机架:

市电直供配电技术:服务器自带电池,支撑到备用电源启动,额外充电蓄电池作为备份电源。

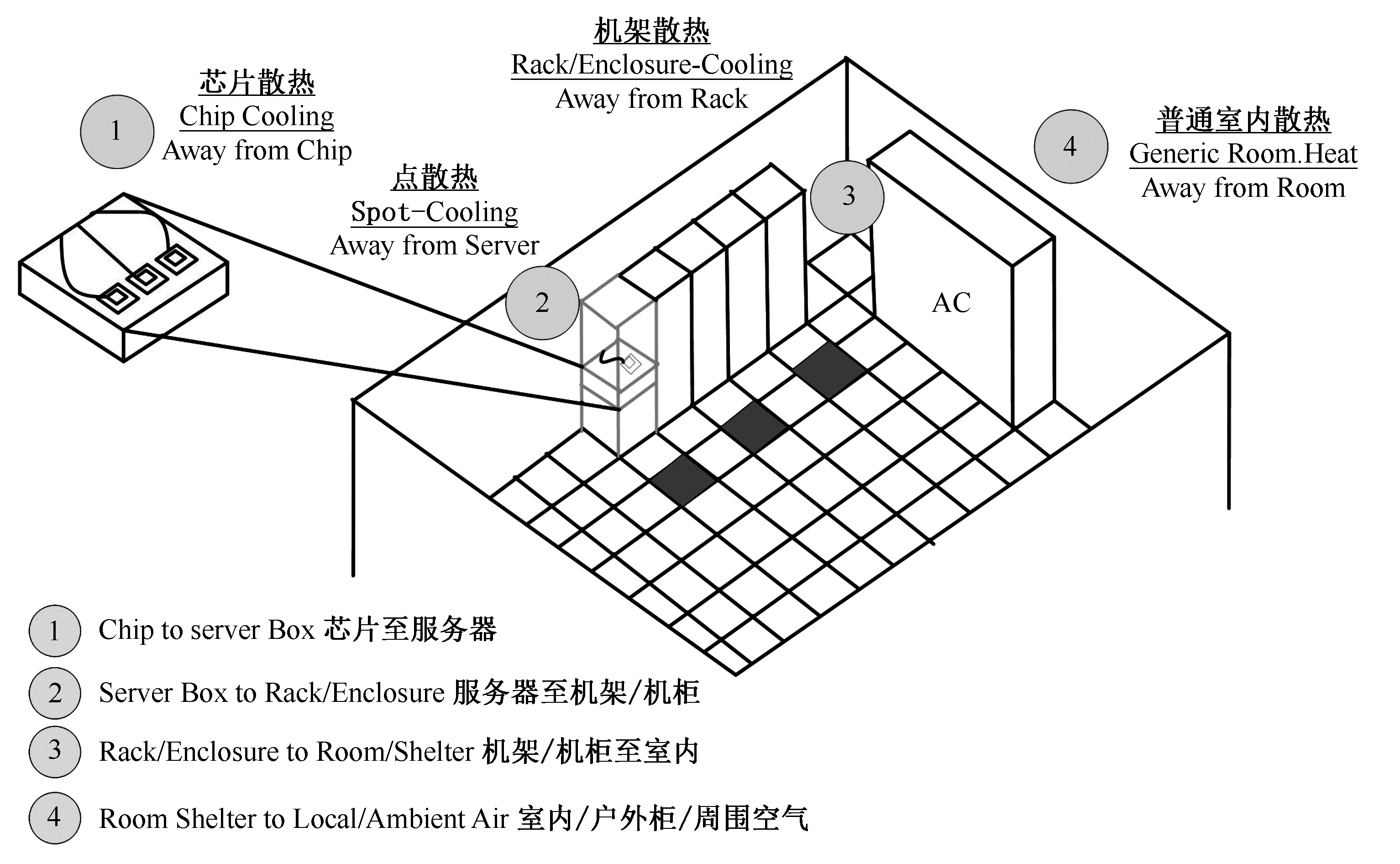

空调系统节能

数据中心中服务器节点、网络设备、办公环境等时刻产生热量,如果不及时散热,数 据中心将无法运行。

空调系统作为数据中心必备得基础设施,用于保证适合的温湿度。

高温回风空调系统:

- 提高空调出供水和回水温度,有助于降低空调能耗(10 供水 15 回水,23~27 服务器送风)

- 精确制冷空调

- 机架冷热通道密封:盲板密封空余处,避免冷热混合,提高热风收集密度

- 机架背面安装冷水板,或机架式精密空调:辅助功耗大的机架散热

- 芯片级散热:热管换热器或相变制冷系统冷却核心发热元器件

- 低能耗加湿系统:湿膜加湿系统或水喷雾系统

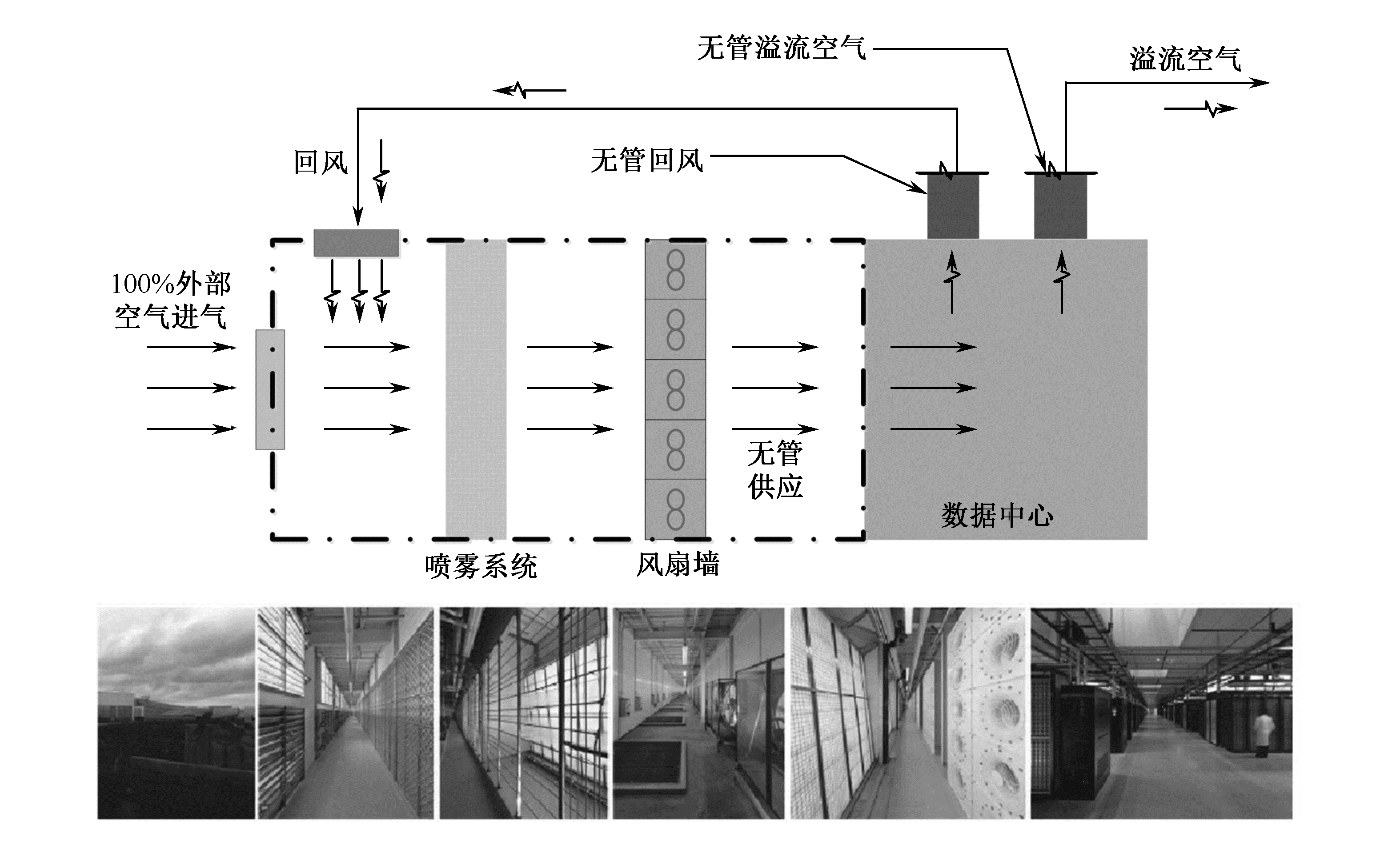

自然冷空调系统:

- 新风自然冷系统,能效比 EER(制冷量/制冷电能耗)由 2-3.5 提高到 10-15:低温或降温风系统、新风过滤系统、气流组织、智能控制

- 水自然冷系统,能效比 EER 6~8

集装箱数据中心节能技术

将数据中心的服务器设备、网络设备、空调设备、供电设备等高密度地装入固定尺寸 地集装箱中,成为数据中心的标准构建模块。

集装箱网络和电力互通,构建完整数据中心。

特点:高密度、模块化、按需快速部署、移动便捷

诸多良好的绿色节能设计:

- 缩短送风距离

- 提高冷通道温度

- 冷热通道完全隔离

- Free Cooling 功能

节能策略和算法研究

功率管理和降低能耗两个角度:

- 动态功率管理(Dynamic Power Management,DPM):Dynamic Voltage & Frequency Scaling,DVFS,动态电压/频率调整

- 静态功率管理(Static Power Management,SPM):通过设备结构的改变降低能耗

关闭开启技术、虚拟机技术等

DVFS:当 CPU 未被完全利用时,降低 CPU 供电电压和时钟频率主动降低 CPU 性能

虚拟机节能:虚拟机迁移实现负载合并,转换闲置节点为节能模式;虚拟机能耗管理;最大化空闲物理机数量;基于蚁群算法的虚拟资源分配策略等。

主机关闭/开启节能:随机策略、超时策略和预测式策略

其他:如冷却系统节能等

新能源应用

实现绿色 IT 的方式:高能效+新能源。开发利用可再生能源,太阳能、生物质能、风能等

现在,越来越多的 IT 企业和机构正在逐步实现完全或者部分新能源驱动的数据中心。

如:谷歌上海数据中心,Facebook 太阳能数据中心,谷歌风能数据中心。

典型的绿色节能数据中心

| 数据中心 | PUE | 特征 |

|---|---|---|

| 雅虎“鸡窝”式数据中心 | 1.08 | 建筑能够“呼吸” |

| Facebook 数据中心 | 1.15 | 凉爽干燥的气候 |

| 谷歌比利时数据中心 | 1.16 | 纯自然风冷系统 |

| 惠普英国温耶德数据中心 | 1.16 | 利用凉爽的海风 |

| 微软都柏林数据中心 | 1.25 | 利用冷空气冷却 |

自动化管理

内容和特征

使得在规模较大的情况下,实现较少人员对数据中心的高度智能管理。

工作范围:按需分配和收回服务器、存储、网络、应用程序

具体内容:资源的自动化调度和对业务的灵活响应,即需要单个业务能自治管理,也需要一个负责全局控制和协调的中心,对业务和资源进行统一监控、管理和调度。

五个特征:

- 全面的可视性——基础设施、中间件、数据库、应用层、业务服务层的运行时视图,全面掌握数据中心资产、配置和各层次依赖关系的现状

- 自动的控制执行——全面自动化数据中心的流程管理

- 多层次的无缝集成——流畅地自动执行在不同层次和组成部分之间地各种处理流程,快速的协调数据中心内外的所有变更,实现端到端的流程管理

- 综合与实时的报告——提供全面综合和透视依赖关系的报告提高管理水平

- 全生命周期支持——自动化整个“计划—实施—检查—更正”的 IT 流程生命周期

实现

由于资金、效率等问题,不可能一蹴而就,经历三个阶段:

- IT 服务操作:监控和管理 IT 基础设施的广义集合,如网络、服务器、应用和现关存储设备

- 目标:生成有效的全局 IT 支撑架构,提高 IT 服务质量,对活动和过程进行协调和执行

- 活动和过程:事故管理、事件监控和管理、问题管理

- IT 服务管理:制定设施间的交互和协作处理,确保 IT 服务符合标准规范

- 定义:根据客户需求的层次确保 IT 服务质量的一系列过程

- 主题:服务管理、服务层管理、IT 资产管理、财务管理

- 数据中心自动化:维护 IT 环境,定制、检查和执行服务层协议

采用数据中心自动化工具必须具备如下条件:

- 管理系统:支持各类 IT 管理软件,能管理、监控、探测、识别和解决 IT 设施的异常行为。

- 定义过程:一套基本明确定义的流程并能运作良好,应包括事件管理、变更管理、配置管理和版本管理。

- 认知非自动化过程的成本:必须知道非自动化过程的成本,避免为了自动化而自动化。

- 内部流程资源:在初始配置时可使用外部资源,但是在后续的维护中,使用内部资源是更节约并有效的。

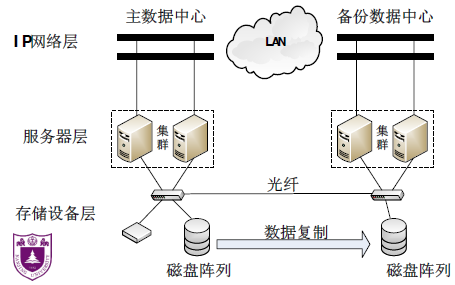

容灾备份

容灾备份是通过在异地建立和维护一个备份存储系统,利用地理上的分离来保证系统和数据对灾难性事件的抵御能力。

层次

容灾系统对灾难的抵抗程度分为:

- 数据级容灾:数据级容灾只保证数据的完整性、可靠性和安全性,但提供实时服务的请求在灾难中会中断。

- 应用级容灾:应用级容灾系统能够提供不间断的应用服务,让服务请求能够透明地继续运行,保证数据中心提供的服务完整、可靠、安全。

两个技术指标:

- 数据恢复点目标 Recovery Point Objective,RPO:主要指业务系统所能容忍的数据丢失量

- 恢复时间目标 Recovery Time Objective,RTO:主要指所能容忍的业务停止服务的最长时间

标准等级

关键技术

核心:复制数据

- 远程镜像技术:主从镜像系统;远程复制;数据传输失败,数据不一致;延迟复制技术

- 快照技术:将远程存储系统中的信息备份到磁带库、光盘库;通过软件对要备份的磁盘子系统的数据快速扫描;备份数据复制到缓冲区,存在缓冲区调度的问题

- 基于 IP 的 SAN 的远程数据容灾备份技术:将主数据中心 SAN(Storage Area Networks)中的信息通过现有 TCP/IP 网络远程复制到备份中心 SAN 中;可跨越 LAN、MAN、WAN,成本低可扩展性好

- 数据库复制技术:数据必须实时、准确、可在线查询;数据复制具有独立性、配置简单、便于监控

Spanner:谷歌的可扩展、多版本、全球分布式、同步复制数据库